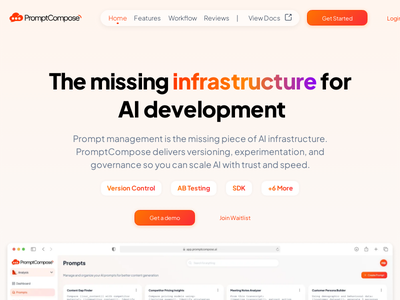

PromptCompose - Beta - The command center for your AI prompts.

PromptCompose是一个专注于AI提示词工程与管理的SaaS平台。它旨在帮助用户更高效地创建、测试、迭代和组织AI提示词,从而提升AI模型(如GPT系列、文生图模型等)的输出质量和一致性。网站首页清晰展示了其核心价值——提高提示词的效率、协作性和性能。主要功能包括直观的用户界面、版本控制、协作工具、性能追踪、模板库以及AI助手集成。适用于需要频繁与AI互动并优化其输出的开发者、内容创作者、营销人员和研究者。

Promptcompose.ai 网站解析

产品经理角度

1. 解决的核心问题:

Promptcompose.ai 旨在解决当前AI应用开发中,尤其是在大型语言模型(LLM)领域,以下几个核心痛点:

- Prompt工程的复杂性与低效: 撰写有效、可复用、可扩展的prompt(指令)是一个高度迭代且耗时的过程,涉及大量试错。

- Prompt管理与版本控制缺失: 随着项目发展,prompt数量增加,缺乏统一的管理、版本控制和回溯机制,导致混乱和难以维护。

- 团队协作障碍: 多个开发者或团队成员共同开发AI应用时,难以共享、评审和协同优化prompt。

- 性能与成本优化: 开发者需要反复测试不同prompt在不同模型上的表现,以优化输出质量、响应速度和token消耗,但缺乏系统化工具。

- 标准化与复用性不足: 优秀的prompt难以被标准化、组件化,导致重复劳动和知识难以沉淀。

2. 目标用户:

- AI开发者/工程师: 使用LLM构建应用程序、聊天机器人、自动化工具的技术人员。

- 数据科学家/ML工程师: 需要对模型行为进行精细控制和调优的专业人士。

- 产品经理/技术内容创作者: 需要测试和优化AI生成内容的产品或内容策略师。

- 企业开发团队: 寻求提高AI应用开发效率和质量的组织。

3. 产品核心功能与用户体验(UX):

- 可视化Prompt构建器: 提供结构化界面,允许用户通过拖拽或模块化方式构建复杂prompt(如包含System、User、Assistant角色,上下文管理,变量插入等)。这大大降低了prompt编写的门槛。

- 多模型测试环境: 支持集成多种主流LLM(如OpenAI, Anthropic, Google Gemini等),允许用户在同一界面下并行测试不同模型对同一prompt的响应,便于对比和选择。

- 版本控制与历史记录: 自动或手动保存prompt的每次迭代,支持回溯、比较不同版本,这是工程化非常关键的一环。

- 结果对比与分析: 提供清晰的界面展示不同模型或不同版本prompt的输出结果,可能包含基本的评价指标(如token数、响应时间)甚至可自定义的评估。

- 模板与复用: 允许用户保存常用prompt为模板,或创建可复用的prompt组件,提高开发效率。

- 团队协作与分享: 支持将prompt分享给团队成员,进行评审、评论和协同编辑。

- API集成与部署: 能够通过API将优化后的prompt无缝集成到实际应用中,甚至可能提供一键部署功能。

- UI/UX: 界面通常会设计得简洁、直观,聚焦于prompt的构建、测试和管理流程,确保开发者能快速上手并高效工作。

4. 优势与不足:

- 优势:

- 痛点切入精准: 直接解决了AI开发中最繁琐、最缺乏工具支持的环节。

- 提高效率: 大幅缩短prompt迭代周期,加速AI应用开发。

- 工程化管理: 引入版本控制和结构化管理,提升代码质量和可维护性。

- 促进协作: 为团队提供统一的prompt工作台。

- 赋能非技术人员: 可视化构建器让更多人能参与prompt设计。

- 不足/改进空间:

- 深度评估与A/B测试: 除了基本对比,是否能提供更深度的评估指标、用户反馈收集、自动化A/B测试功能,以更科学地优化prompt?

- 成本与性能监控: 更细粒度的token消耗、API调用成本、延迟等实时监控和报告,帮助用户进行成本效益分析。

- 高级调试: 如何处理模型拒绝、偏见、幻觉等复杂情况?是否能提供更智能的调试建议?

- 社区与市场: 缺乏一个公开的prompt模板市场或社区,用户可以分享、发现和购买高质量的prompt,这将极大丰富产品生态。

- 集成生态: 与主流IDE、CI/CD流程、数据存储、向量数据库的深度集成。

- 模型训练与微调集成: 如果能与prompt微调或少量训练数据管理结合,将更有竞争力。

5. 产品路线展望:

从“Prompt构建工具”发展为“Prompt工程生命周期管理平台”,涵盖从设计、测试、部署、监控、优化到归档的整个流程。未来可拓展至:AI代理的规划与编排、AI任务流自动化、特定领域知识库构建等。

投资人角度

1. 市场机会(Market Opportunity):

- 快速增长的AI市场: LLM是当前最热门且增长最快的技术领域之一,所有基于LLM构建应用的公司都需要高效的Prompt工程。

- 新兴且必需的赛道: Prompt工程是一个新的、但极度关键的“岗位”和“技能”,市场对相关工具的需求呈指数级增长。

- 巨大的潜在用户群体: 从独立开发者到大型企业,任何利用LLM的公司都是潜在客户。

- 解决核心痛点: 解决了LLM应用开发中效率低下、管理混乱的根本性问题,痛点明确且普遍。

2. 商业模式与营收潜力:

- SaaS订阅模式:

- 免费增值(Freemium): 提供基础功能免费,吸引用户。

- 分级订阅(Tiered Subscription): 根据用户数量、prompt数量、测试次数、模型集成数量、高级功能(如A/B测试、团队协作、企业级安全)等维度进行收费。

- 企业级解决方案: 为大型企业提供定制化服务、SLA保障、私有化部署、SSO等,获取高价值客户。

- 潜在增值服务:

- Prompt市场/商店: 允许用户出售或购买高质量、特定场景的prompt模板,抽取佣金。

- AI API代理/优化: 如果能成为一个调用层,通过优化路由、缓存来降低用户AI API成本,并从中分成。

- 专业服务/咨询: 提供Prompt工程咨询服务。

- 营收潜力: 如果能成为Prompt工程领域的“GitHub”或“Jira”,其订阅收入将非常可观,具备高毛利和高续费率的SaaS特性。

3. 竞争格局与竞争优势:

- 直接竞争: 存在其他Prompt管理和测试工具(如LangChain Hub, Weights & Biases Prompts, Vercel AI SDK的一些功能,或企业内部自建工具)。

- 间接竞争: 大型云服务商(如Azure OpenAI Service, Google AI Platform)或AI模型提供商可能会在自家平台内置类似功能。

- 竞争优势(Moat):

- 先发优势: 快速占领用户心智,成为Prompt工程的“标准工具”。

- 用户体验与易用性: 简洁、高效的UI/UX是吸引开发者的关键。

- 深度集成: 与各类LLM、开发工具、云平台建立广泛且深度的集成。

- 社区与生态: 建立活跃的开发者社区,形成prompt分享和协作的良性循环。

- 数据与智能: 通过分析用户prompt数据(需匿名化和用户授权)提供智能优化建议,提升工具的智能性。

- 企业级功能: 针对企业用户提供更强的安全、合规、管理功能。

4. 风险评估:

- 技术快速迭代风险: LLM技术发展极快,Prompt工程范式可能发生变化(例如,模型自我优化能力增强,对人工Prompt依赖降低),需要产品持续适应。

- 平台锁定风险: 如果主流AI模型提供商(如OpenAI, Anthropic)将类似功能深度集成到自家平台,可能削弱第三方工具的市场空间。

- 竞争加剧: 随着市场成熟,会有更多玩家进入,包括资金雄厚的大公司。

- 用户付费意愿: 开发者习惯使用免费工具,如何证明产品价值并转化为付费用户是挑战。

- 数据隐私与安全: 处理用户prompt可能涉及敏感数据,安全和合规性是重要考量。

5. 投资建议:

Promptcompose.ai 处于一个极具潜力的市场赛道。如果团队具备以下条件,将是值得关注的投资标的:

- 强大的产品愿景与执行力: 能够快速迭代,持续推出有价值的功能。

- 深厚的技术背景: 尤其是在LLM和SaaS产品开发方面。

- 清晰的Go-to-Market(GTM)策略: 如何获取用户并将其转化为付费客户。

- 有效的市场教育能力: 帮助开发者理解Prompt工程的价值和工具的必要性。

- 构建生态的能力: 不仅仅是一个工具,更是一个平台。

结论: Promptcompose.ai 解决了AI应用开发中的核心痛点,市场潜力巨大,商业模式清晰。但需要密切关注其产品迭代速度、用户获取成本、付费转化率以及应对技术和市场变化的灵活性。若能克服风险并建立强大的竞争壁垒,有望成为Prompt工程领域的头部平台,具有显著的投资价值。